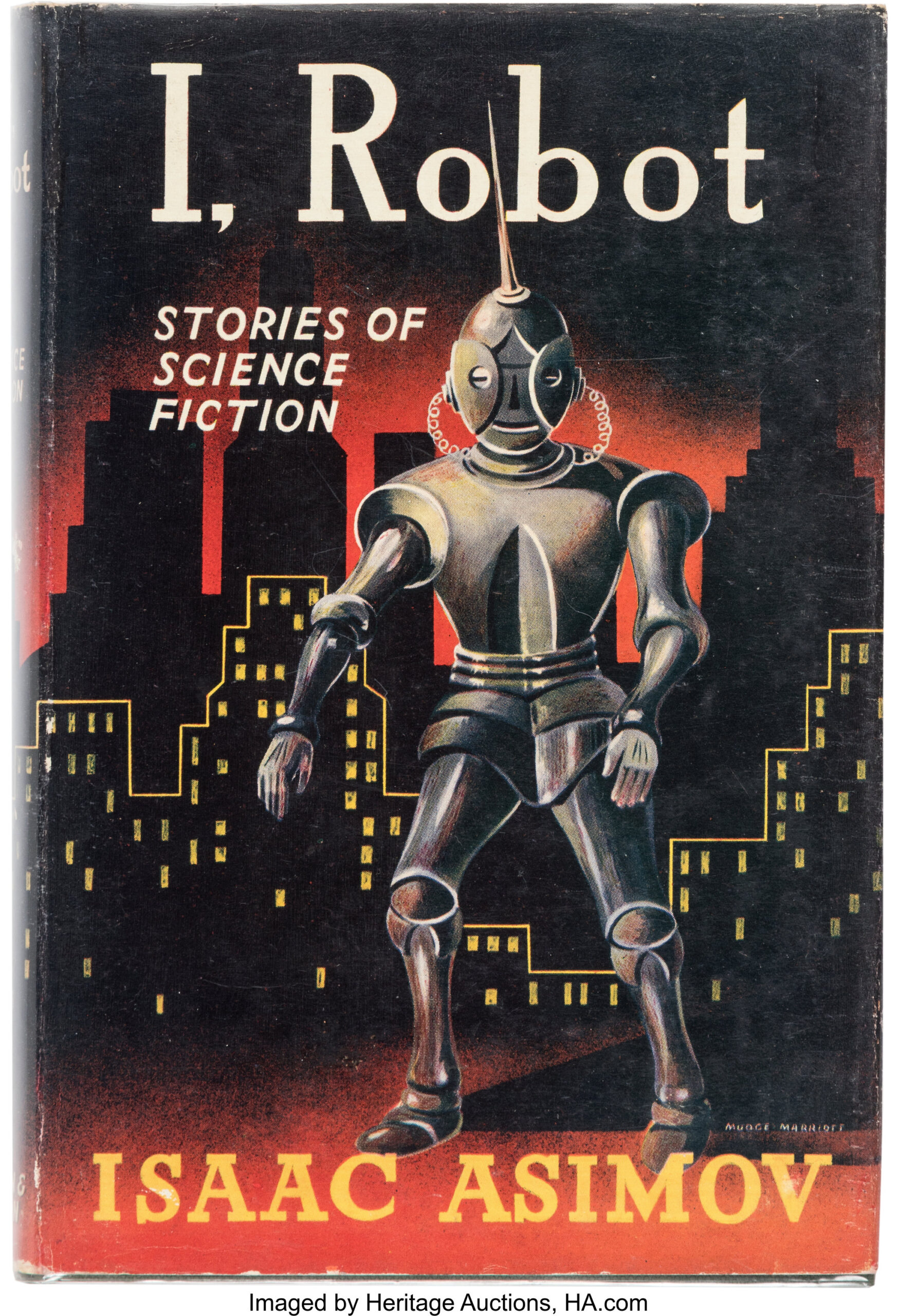

Trzy prawa robotyki

W 1942 roku amerykański pisarz i profesor biochemii, Isaac Asimov wydał opowiadanie science fiction pt. „Zabawa w berka”. Przedstawił w nim trzy sformułowane przez siebie prawa robotyki. Miały one regulować przyszłe stosunki między ludźmi i maszynami. Brzmiały one następująco:

- Robot nie może skrzywdzić człowieka ani przez zaniechanie działania dopuścić, aby człowiek doznał krzywdy.

- Robot musi być posłuszny rozkazom człowieka, chyba iż stoją one w sprzeczności z Pierwszym Prawem.

- Robot musi chronić samego siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

43 lata później Asimov doszedł do wniosku, iż potrzebne pozostało jedno prawo. W swoim opowiadaniu „Roboty i Imperium” ustanowił prawo zerowe, nadrzędne wobec trzech pozostałych:

0. Robot nie może skrzywdzić ludzkości lub poprzez zaniechanie działania doprowadzić do uszczerbku dla ludzkości.

Tak sformułowane zasady brzmią dość… katastroficznie. Stały się one jednak podstawą do myślenia o potencjalnych konsekwencjach projektowania sztucznej inteligencji (AI). Odniesienia do trzech praw Asimova znaleźć można choćby dziś w dziełach kultury takich jak film „Ja robot” czy Netflixowym serialu „Better than us” z 2019 roku.

Należy pamiętać, iż powieść ta powstała w latach 40, gdy nie do końca wiadomo było, w jakim kierunku i jak gwałtownie rozwinie się robotyka. Zasady te formułowane były z myślą o sztucznej inteligencji w formie cyborgów, androidów. Dziś możemy przypuszczać, iż zaawansowana AI, raczej nie przyjmie formy terminatora. W końcu już teraz AI jest integralną częścią naszej codzienności i najczęściej występuje pod postacią aplikacji, programów czy asystentów takich jak Siri. Czy zatem mamy się w ogóle czego obawiać?

Czy ufasz temu komputerowi?

Sztuczna inteligencja nie przestanie się rozwijać. Jej sukcesy na polu medycyny, komunikacji czy rozrywki są tak spektakularne, iż nie ma szans, by ludzkość jednogłośnie zdecydowała się zaprzestać pracy nad nią.

W swoim wystąpieniu na konferencji TED Sam Harris mówi nawet, iż na aktualnym etapie, jedyne co może nas powstrzymać od ulepszania inteligentnych maszyn to… koniec cywilizacji. I to właśnie opłacalność rozwijania AI może być najbardziej problematycznym elementem tego przedsięwzięcia.

Kusząca jest wizja stworzenia AI, które będzie w stanie projektować coraz inteligentniejsze wersje samej siebie. Grupa będąca w posiadaniu takiego programu mogłaby w ciągu dni, tygodni wyprzedzić cały świat pod względem technologii o tysiące lat. W takiej perspektywie nieunikniony wydaje się światowy wyścig technologiczny.

Niezwykle istotne jest więc, by stworzyć AI odpowiednie warunki do rozwoju. Warunki ograniczające monopolizację tej technologii. Warunki kładące nacisk na wirtualne testy i pracę takiej AI w zamkniętym środowisku, przed wypuszczeniem jej w świat.

No dobrze, ale czy jeżeli coś pójdzie nie tak, to nie możemy jej po prostu wyłączyć?

Cóż, Sam mówi, iż gdy AI już się rozwinie, to jej wyłączenie będzie równie proste co wyłączenie całego internetu. Czy ktoś wie może, gdzie jest wyłącznik do internetu?

Dlaczego adekwatnie mamy dylemat?

AI, żeby wykonywać narzucone jej zadania i rozwijać się w jakimś celu, potrzebuje zachęty. Najczęściej jest po prostu nagroda w postaci zwiększenia licznika punktów za wykonanie jakiejś pożądanej czynności. AI uczone jest, iż im większy wynik na liczniku, tym lepiej.

Działa to świetnie, gdy AI uczy się odróżniać chihuahuę od muffina. Psa pasterskiego od mopa czy dalmatyńczyka od lodów (AI ma najwyraźniej jakiś problem z psami). AI jest wtedy nagradzane, jeżeli jego wybory zgadzają się z odpowiedziami ludzi (Zastanawialiście się kiedyś, dlaczego w celu weryfikacji musicie wybrać wszystkie obrazki z sygnalizacją świetlną? Te dane nie idą w kosmos ;) )

Komplikacje mogłyby wystąpić natomiast, gdyby inteligencja otrzymała za zadanie utrzymywać porządek w zlewie w kuchni. Mogłaby wtedy być nagradzana na przykład za ilość zużytego płynu do naczyń.

Czy byłby to dobry pomysł? Możliwe, iż tak, dopóki AI nie uznałaby, iż najlepszym sposobem jest wylanie całego płynu do naczyń do zlewu.

W takim razie może warto nagradzać ją za poziom czystości? Cóż, wtedy może dojść do wniosku, iż to ludzie są głównym powodem powstawania brudu, dlatego trzeba się ich pozbyć.

Innym, równie przesadzonym przykładem będzie ten z trudnym problemem matematycznym. AI, próbując go rozwiązać, może uznać, iż najlepszym sposobem będzie przerobienie całej ziemi na jeden wielki superkomputer. Dzięki temu będzie miała ona wystarczające zasoby do rozwiązania zagadki. Za wszelką cenę.

Wyobraźni czytelników pozostawiam, w jaki sposób AI mogłaby sprawić, by wszyscy ludzie na ziemi się uśmiechali.

Powyższe eksperymenty myślowe są oczywiście przekoloryzowane. Niemniej jednak musimy pamiętać, iż gdy AI stanie się od nas inteligentniejsza, możemy mieć trudności ze zrozumieniem jej działań. Bardzo łatwo wtedy o nieporozumienie czy utratę kontroli (abstrahując oczywiście od problemów moralnych związanych z kontrolowaniem innego inteligentnego bytu — ale to temat na inny artykuł :))

Przyziemne problemy z AI

Dylemat nie dotyczy tylko sztucznej inteligencji w swojej przyszłej, „wszechmocnej formie”. Już dzisiaj, na początku naszej drogi napotykamy problemy z AI. Przykłady błędów można znaleźć już w tak prostej wydaje się czynności, jak dostarczanie AI danych do nauki.

W 2014 roku Amazon wprowadził do swojego systemu rekrutacyjnego zaprojektowaną przez siebie sztuczną inteligencję. Miała ona pomóc w wyszukiwaniu i segregacji potencjalnych kandydatów i kandydatek na stanowiska w firmie.

Rok później okazało się, iż działanie AI jest… problematyczne. Była ona bowiem niechętnie nastawiona do CV wysyłanych przez kobiety. Wynikało to z faktu, iż została ona nakarmiona danymi z ostatnich 10 lat, wśród których znaczną większość stanowili mężczyźni. Problemem był zatem niedobór danych.

W 2017 Amazon usunął projekt.

Powyższa sytuacja nie pozostało katastrofalna — z takiego projektu zawsze można się wycofać, poprawić go, wypróbować na nowo. Gorzej, gdy stronnicza stanie się inteligencja na poziomie człowieka lub wyższym.

Inny przykład: Już dziś mamy do czynienia z istnieniem technologii deepfake, o której wspominaliśmy w tym artykule. w uproszczeniu — polega ona na tworzeniu filmów czy nagrań, w których sztuczna inteligencja imituje udział prawdziwej (lub fikcyjnej) osoby.

Zastosowanie tej technologii na polu polityki może wywołać panikę społeczną (Przykład: Vladimir Putin ostrzegający rząd USA przed ingerencją w wybory) lub być podstawą przemocy wobec jakiejś osoby (np. poprzez sfabrykowanie treści pornograficznej z jej udziałem).

Istotne jest więc istnienie i egzekwowanie konkretnych przepisów prawnych, które będą chronić przed niebezpiecznym użyciem tej technologii. Yuval Harari, autor książki „Sapiens” w swoim wywiadzie udzielonym w 2021 dla CBS apeluje, iż już teraz jest najwyższy czas, by zacząć ściśle regulować wykorzystanie AI. W przeciwnym razie, poza powyższymi przykładami możemy mieć do czynienia również z „hakowaniem” ludzi przez wielkie korporacje.

„Zhakować człowieka, to poznać go lepiej, niż on sam siebie zna. I na tej podstawie stopniowo manipulować nim”

Netflix mówi nam co oglądać, Amazon mówi nam co kupować. Facebook mówi nam, co dzieje się na świecie i w naszych kręgach. TikTok i Youtube dobierają nam rozrywkę.

Harari mówi, iż w ciągu 30 lat spersonalizowane wyniki algorytmów mogłyby również powiedzieć nam co studiować, gdzie pracować, kogo poślubić lub choćby na kogo głosować.

Dlaczego nie panikujemy?

W 2022 roku przeprowadzono wśród ekspertów z dziedziny AI badanie dotyczące przewidywań nt. rozwoju sztucznej inteligencji. Zbiorczo odpowiedzieli oni, iż z 50% prawdopodobieństwem AI osiągnie poziom inteligencji człowieka do roku 2060. W przypadku roku 2100 prawdopodobieństwo to było już w granicach 85%. W uproszczeniu — zostało nam średnio około 50 lat.

Stuart Russell, brytyjski specjalista w dziedzinie AI powiedział:

“Wyobramy sobie, iż dostajemy wiadomość od obcej cywilizacji. Brzmi ona następująco:

Ziemanie, przylecimy do was w ciągu 30 do 50 lat. Przygotujcie się”.

Jaki byłby rezultat takiej wiadomości? Zakładając, iż informacja ta dotarłaby do opinii publicznej — ludzkość wpadłaby w panikę. Po obowiązkowej chwili chaosu prawdopodobnie postaralibyśmy się jednak wykorzystać pozostały czas, żeby być przygotowanym na przybycie obcych.

Dlaczego więc nie robimy tego samego w odniesieniu do rozwoju AI?

Cóż, ludzie nie są zbyt dobrzy w uzmysławianiu sobie długoterminowego niebezpieczeństwa. Z tego samego powodu na co dzień raczej nie przeżywamy globalnego ocieplenia.

Łatwo nam sobie wyobrazić jedno nagłe wydarzenie, takie jak trzęsienie ziemi czy wybuch pandemii. Znacznie trudniej stworzyć w głowie wizję zagrożenia powstającego przez dziesięciolecia. A skoro nie ma wyobrażenia, to nie ma związanych z nim emocji i strachu. Bez strachu nie ma natomiast działania, które ma ten strach przezwyciężyć. choćby jeżeli stres powstaje, to mamy w głowie najlepszą z wymówek — iż mamy jeszcze mnóstwo czasu.

Aktualne i przyszłe zasady rozwoju AI

Na szczęście istnieją i wciąż powstają nowe organizacje i regulacje, które mają na celu nadzorować rozwój AI.

W czerwcu 2020 roku powstała najbardziej znana na tym polu organizacja — Global Partnership on Artificial Intelligence. Zajmuje się ona kontrolą rozwoju AI. Eksperci z GPAI dbają, żeby następował on we właściwym tempie, zgodnie z prawami człowieka i wartościami demokracji.

Oprócz tego istnieje również wiele organizacji zajmujących się rozwojem AI na mniejszych terytoriach. Własne działania na tym polu przeprowadza m.in Kanada, Chiny, Wielka Brytania, Stany Zjednoczone czy Unia Europejska.

Komisja Europejska zajmuje się aktualnie wprowadzeniem regulacji na polu określania ryzyka poszczególnych działań związanych z AI i związanych z nimi wymagań.

Takie działania na skalę globalną, kontynentalną czy krajową są niezwykle ważne. Jako ludzkość chcemy mieć pewność, iż gdy naprawdę inteligentna AI już się pojawi, to będzie to efekt wspólnego wysiłku i odpowiedzialności całego świata.

Stworzenie nowej, inteligentnej istoty to wyzwanie na poziomie, z jakim ludzkość nie miała dotychczas szansy się mierzyć. Nie możemy dopuścić, by stało się to wyścigiem technologicznym na miarę pierwszego wysłania człowieka w kosmos.

3 lat temu

3 lat temu