Materiały deepfake są coraz częściej wykorzystywane i rozpowszechniane w trakcie wyborów. Analiza 36 procesów wyborczych (parlamentarnych, regionalnych i prezydenckich) w ciągu ostatnich 6 miesięcy potwierdza realne zagrożenie i obawy o integralność i niezależność procesów wyborczych. W 10 krajach doszło do manipulacji treścią informacji i przekazów medialnych, w tym w Polsce. Falę krytyki wywołał film ze sfałszowanym głosem byłego premiera Mateusza Morawieckiego przygotowany przy pomocy AI.

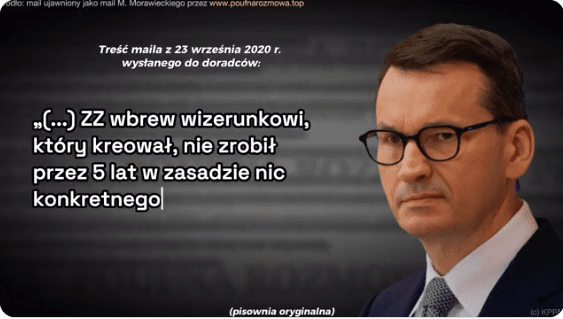

Mowa o spocie wyborczym przygotowanym pod koniec 2023 roku przez sztab największej polskiej partii politycznej, Platformy Obywatelskiej (PO), w którym połączono autentyczne fragmenty wypowiedzi Mateusza Morawieckiego z wygenerowanym przez sztuczną inteligencję głosem premiera. Zaledwie kilka godzin po opublikowaniu filmu PO wyjaśniła, iż część materiału została wygenerowana sztucznie, po tym jak spotkała się z powszechną krytyką ze strony komentatorów i ekspertów.

Analitycy Check Point Research zwracają uwagę na Polskę jako jeden z ewidentnych przykładów potwierdzających obawy o przebieg procesów wyborczych. Uważają, iż postęp w zakresie wyrafinowania i dostępności generatywnej sztucznej inteligencji zwiększył obawy o integralność procesu wyborczego.

– Nasze badanie dotyczące wykorzystania sztucznej inteligencji w kampaniach wyborczych na całym świecie ukazuje przerażającą ewolucję cyfrowej wojny przeciwko procesom demokratycznym. Zaawansowanie i dostępność technologii sztucznej inteligencji osiągnęły punkt, w którym można je łatwo wykorzystać jako broń, aby wpłynąć na proces demokratyczny. Konieczne jest podnoszenie świadomości, wspieranie współpracy międzynarodowej i aktualizacja ram regulacyjnych, aby przeciwdziałać takim zagrożeniom – podkreśla Sergey Shykevich, szef grupy Threat Intelligence Group w firmie Check Point Software.

W wielu przypadkach sztuczną inteligencję wykorzystywano do generowania materiałów tradycyjnie wytwarzanych przez pracowników kampanii lub wynajętych konsultantów ds. mediów. Widać to wyraźnie na przykładach od Argentyny po Indonezję. Pozytywnym aspektem tych narzędzi jest ich wykorzystanie do ominięcia ograniczeń wolności słowa, jak miało to miejsce w przypadku próby pokazania na wizji uwięzionego przywódcy politycznego w Pakistanie (Khan) lub godnej uwagi próby zapewnienia głosu wyciszonej białoruskiej opozycji. – Musimy przestrzec, iż narzędzia służące animowaniu pomysłów na kampanie często skutkują mylącymi zastosowaniami, takimi jak wkładanie w usta zmarłych przywódców słów poparcia dla obecnych polityków (taktyka stosowana w Indonezji i Indiach) czy niezweryfikowane treści e-maili wypowiadane fałszywym głosem (jak w Polsce) – podsumowuje analiza firmy Check Point. Kampanie dezinformacyjne uznano za podstawowe narzędzie w społeczeństwach autokratycznych, natomiast w demokracjach podwyższony poziom dezinformacji wiąże się z początkami autokracji. W związku z tym prawdopodobne jest, iż wykorzystanie narzędzi sztucznej inteligencji do dezinformacji jest bardziej powszechne w krajach autokratycznych, wadliwych demokracjach i krajach będących celami reżimów autokratycznych.

Eksperci firmy Check Point Research zbadali 36 procesów wyborczych (parlamentarnych, regionalnych i prezydenckich), które odbyły się w ciągu sześciu miesięcy od września 2023 r. do lutego 2024 r. wskazując na co najmniej 10 przypadków (w tym Polskę), gdzie doszło do prób dezinformacji przy użyciu sztucznej inteligencji.

Zdolność sztucznej inteligencji do tworzenia niskim kosztem spersonalizowanych treści na masową skalę, w połączeniu z jej potencjałem w zakresie tworzenia wysoce realistycznych, a jednocześnie fałszywych materiałów audiowizualnych wzbudza obawy ekspertów. Pojawiają się wątpliwości, czy przyszły dyskurs polityczny nie odwróci uwagi od istotnych kwestii politycznych. Jednocześnie zwracają uwagę na fakt, iż dostępność potencjalnie złośliwych narzędzi sztucznej inteligencji wykracza poza rynki Dark Web. W swoim raporcie analitycy podkreślają porównywalne funkcjonalności dostępne na platformach typu open source. – Obecnie ponad 3000 repozytoriów GitHub poświęconych jest rozwojowi i rozpowszechnianiu technologii deepfake, a usługi oferowane są w cenach zaczynających się już od 2 dolarów za film. Do najbardziej niepokojących należą usługi „deepfake”, które mogą tworzyć bardzo realistyczne choć fałszywe treści audio lub wizualne. Materiały te mogą zostać wykorzystane przez krajowe partie polityczne i kandydatów lub agentów zagranicznych w celu zwiększenia szans konkretnego kandydata lub partii w wyborach, wyrządzenia szkody konkurentom lub podważenia zaufania publicznego do procesu demokratycznego – stwierdzają.

W wielu krajach brakuje w tej chwili odpowiednich przepisów dotyczących materiałów generowanych przez AI. W rezultacie umożliwia to rozpowszechnianie fałszywych plików audio i wideo. Eksperci wskazują najważniejsze obszary, w których sztuczna inteligencja jest szeroko wykorzystywana w kampaniach wyborczych na całym świecie:

1. Przez kandydatów do autopromocji2. Przez kandydatów w celu atakowania i zniesławiania przeciwników politycznych3. Przez podmioty z obcych państw narodowych w celu zniesławienia konkretnych kandydatów

Tymczasem rok 2024 jest kluczowym momentem dla procesów demokratycznych na całym świecie, ponieważ ponad 2 miliardy osób w 50 krajach przygotowuje się do oddania głosu w wyborach. Ta globalna fala wyborcza obejmuje takie kraje, jak m.in. Stany Zjednoczone, Indie, Meksyk, Parlament Europejski i Polskę.

1 rok temu

1 rok temu

![Od 1 stycznia 2026 r. zmiany w funduszach emerytalnych - co to daje? [ustawa z podpisem Prezydenta RP]](https://g.infor.pl/p/_files/38586000/podwyzka-placy-minimalnej-styczen-2026-38585531.jpg)